Приветствую Вас, дорогие друзья, на блоге firelinks.ru. В сегодняшнем посте речь пойдет о правильной настройке файла robots.txt для того, чтобы наш сайт правильно и быстро проходил индексацию в поисковых системах. Любой админ или вебмастер знаком с этим файлом и не раз сталкивался с проблемами при его правильной настройке. Вкратце, давайте представим, что Ваш сайт – это Ваша квартира, а поисковый робот Яндекса и Гугла это гости, которые решили зайти к Вам на новоселье посмотреть как Вы живете. Так вот, файл роботс это своего рода хозяин квартиры, который должен четко знать куда нужно вести дорогих гостей, а куда им заходить вовсе не положена, так сказать соваться в ваше личное пространство . Для того, чтобы все шло по маслу и требуется настроить данный файл с указанием конкретных команд.

Приветствую Вас, дорогие друзья, на блоге firelinks.ru. В сегодняшнем посте речь пойдет о правильной настройке файла robots.txt для того, чтобы наш сайт правильно и быстро проходил индексацию в поисковых системах. Любой админ или вебмастер знаком с этим файлом и не раз сталкивался с проблемами при его правильной настройке. Вкратце, давайте представим, что Ваш сайт – это Ваша квартира, а поисковый робот Яндекса и Гугла это гости, которые решили зайти к Вам на новоселье посмотреть как Вы живете. Так вот, файл роботс это своего рода хозяин квартиры, который должен четко знать куда нужно вести дорогих гостей, а куда им заходить вовсе не положена, так сказать соваться в ваше личное пространство . Для того, чтобы все шло по маслу и требуется настроить данный файл с указанием конкретных команд.

Зачем нужен robots txt

Сам robots.txt является системным файлом и расположен в корневой директории нашего сайта на Joomla или WordPress. Если Сайт создается на любой другой CMS, то он обязательно будет там. Если же у Вас нет данного файла, то в срочном порядке необходимо его создать с помощью стандартного блокнота и залить на хостинг.

Файл robots на прямую отвечает за индексирование любого сайта и его настройка является архиважной, иначе, Вы получите головную боль и Ваш проект просто будет топтаться на одном месте, а то и вообще улетит далеко назад.

Теперь рассмотрим какие вообще бывают типы поисковых роботов и их назначение. Основной упор конечно делаем под Яндекс и Гугл, так как именно оттуда нам нужен качественный трафик для нашего сайта. У Яндекса, помимо основного робота, существует также и вспомогательные боты в количестве около 10 штук, которые также участвуют в формирование общего анализа сайтов и порядка их выдачи.

Вот какие бывают роботы у Яндекса:

- “Яндексбот” – Основной поисковый робот индексирующий все ресурсы сети;

- “Яндекс Медиа” – Робот, занимающийся поиском и анализом медийных элементов;

- “Яндек Каталог” – Предназначен для снятия заброшенных, или не рабочих ресурсов из каталога Яндекса;

- “Яндекс Имейджес” – предназначен для индексирования картинок;

- “Яндекс Ньюс” – индексирует новостные разделы сайтов;

- “Яндекс Блогс” – предназначен для индекса новых постов и комментарий на блогах, производит поиск по блогам.

Если в самом файле robots.txt прописаны основные директивы к конкретному роботу, то общие правила работы на него уже не действуют. Но, указание команд конкретно к каждому роботу, требует достаточных знаний в этой области и поэтому советую оставить эту затею и прописать в файле робота только общие директивы на индексирование Вашего сайта.

Таким образом Вы можете настроить под свои нужды любого робота и манипулировать этим.

Правильный robots txt для сайта

Мы рассмотрим настройку данного файла на примере движка Джумла 3.3. После установки дистрибутива Джумла (как установить оболочку Денвер для движка Джумла читаем здесь), содержание файла роботс выглядит следующим образом:

Теперь нам нужно разобраться, что вообще значат все эти данные и как их применить к своему сайту. Для каждого сайта я рекомендую приписать отдельно следующие директивы:

User-agent: Yandex – эта запись будет сообщать о том, что данные команды относятся именно к поисковому роботу Яндекса. После этой записи будут идти основные каталоги вашего сайта, которые требуется проиндексировать.

User-agent: Googlebot – основная запись для поискового робота Гугла.

User-agent: * – данная запись будет означать, что правила индексирования каталогов и файлов Вашего сайта будут одни для всех поисковых роботов. Поэтому можно использовать все три записи одновременно, если у Вас особые требования к индексации ресурса. Пробуйте и смотрите как те или иные настройки влияют на скорость индексации и ее качество.

Далее мы рассмотрим основные команды, разрешающие и запрещающие индексацию определенных разделов сайта. Данные команды нам необходимы для того, чтобы избавиться от всевозможного мусора, и дублей страниц, которые может генерировать наша CMS. Первая и очень важная команда для поискового робота это “Disallow:”. Данная директива говорит роботу, что тот или иной раздел сайта индексировать не требуется или же определенную страницу. далее приведу примеры с пояснениями, чтобы разложить все по полочкам. Не стоит новичкам пугаться, все достаточно просто и совсем не трудно, главное уловить суть всего этого. Итак, вот основные на мой взгляд директивы робота которые помогут решить ряд проблем с индексацией и поможет бороться с дублями.

Disallow: – использовать в таком виде не стоит, так как никакого толку от пустой директивы не будет и ее обязательно требуется внимательно заполнять , так как если вы к примеру чистили файл robots.txt и оставили просто слеш “/”, то это будет означать следующее:

Disallow: / – Ваш сайт полностью закрыт от индексации поисковыми роботами. Если Вы поставили такую запись, то в панели вебмастера Яндекса Вы увидите сообщение о том, что робот не может проиндексировать страницы сайта, закрытые находятся в данном файле.

Disallow: /templates/ – так закрывается любая папка (каталог) в CMS Joomla и любой другой CMS. К примеру, данная папка содержит шаблон сайта и все файлы которые к нему относятся, но нам не нужно загружать робота бесполезной информацией технического характера и отвлекать от индексации нужного контента. Запрет индексации robots txt поможет видеть нужный и полезный контент быстрее и выдавать его в поиск.

Таким образом мы можем закрыть любой раздел нашего проекта. А теперь, давайте рассмотрим второй, очень важный элемент в настройке нашего робота, и это будет “Allow:”. Данная команда дает нам возможность открыть определенный раздел или просто нужную страницу сайта. Допустим, мне нужно, чтобы индексировалась страница с нужным мне постом, а остальные были закрыты, тогда вносим такую запись в наш файл:

Allow: /zarabotok-v-seti/145-kak-zarabotat-v-internete-novichku.html

Теперь ставим перед собой задачу. Нам нужно закрыть весь сайт от индексации в Яндексе и оставить открытой только одну нужную страницу для индекса. Вот пример записи такой команды:

User-agent: Yandex

Disallow: /

Allow: /zarabotok-v-seti/145-kak-zarabotat-v-internete-novichku.html

Вроде бы ничего сложного, но стоит намудрить с командами и прописать их с ошибкой, то можно наплодить не только кучу дублей страниц, но и отправить в индекс огромное количество мусора, который роботы будут индексировать неделями. А если Вы публикуете на своем сайте или блоге новые посты, то скорее всего пока они будут индексироваться роботами неделями, их могут копировать на другие ресурсы, а также потеряете ту аудиторию, которая могла увидеть вашу новость, будь она в выдаче поисковых систем.

Еще один не маловажный момент, при запрете индексации robots txt ненужных страниц, является следующая запись:

Disallow: /flash – это будет означать, что все, что находится и начинается с “/flash” будет запрещено для индексации.

Также стоит закрыть от индекса и служебные элементы, такие как печать, лента новостей, авторизация и т.д. Я это сделал следующим образом:

Disallow: /*mailto*

Disallow: /*start*

Disallow: /*print*

Disallow: /*feed*

Disallow: /*search*

Disallow: /*users*

Символ “*” будет означать что любая последовательность как до и после не должна индексироваться.

Для ускорения индексации новых страниц, а также для оказания помощи поисковому роботу при брожении по сайту необходимо ставить карту сайта. Данная карта не представляет никакой пользы для пользователей, пришедших на сайт и имеет расширение типа .xml. У меня на блоге путь к карте выглядит так:

https://firelinks.ru/sitemap.xml

И если данная карта уже готова и лежит в корне сайта, ее в обязательном порядке необходимо указать для индексации следующим образом, используя команду ” Sitemap “:

Sitemap: https://firelinks.ru/sitemap.xml – данную строчку прописываем в самом низу, после пробела от последней записи.

Для установления основного зеркала сайта, нам необходимо не только установить его в панели яндекс-вебмастер как на скрине:

Но, также в файле robots необходимо его прописать, используя директиву “Host”. У меня это выглядит так:

Host: firelinks.ru

Пример кода файла robots txt для Джумла

Ну вот и вроде мы рассмотрели основные директивы и научились закрывать не нужные нам разделы сайтов. В качестве примера, даю Вам свой файл robots.txt для CMS Joomla для поисковой системы Яндекс. Не забудьте поменять данные на свои.

User-agent: Yandex

Disallow: /administrator/

Disallow: /cache/

Disallow: /cli/

Disallow: /components/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /libraries/

Disallow: /logs/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /tmp/

Disallow: *&template=*

Disallow: /xmlrpc/

Disallow: /index.php

Disallow: /index.html

Disallow: /*?

Disallow: /*mailto*Disallow: /*start*

Disallow: /*print*Disallow: /*feed*

Disallow: /*search*

Disallow: /*users*

Host: firelinks.ru

Sitemap: https://firelinks.ru/sitemap.xml

Отлично. Теперь просто копируйте данный файл и ставьте в свой. Но перед установкой обязательно все проверьте, так как папки на разных CMS везде разные и могут отличаться.

Как проверить файл robots.txt на сайте?

Так, Вы уже создали свой файл робота и положили в корень сайта на хостинге. Теперь нам необходимо проверить открывается ли он вообще. Для этого в адресной строке браузера допишем к своему домену такую строчку: /robots.txt. Если открывается страница с директивами, к примеру как у меня:

https://firelinks.ru/robots.txt, значит все сделано правильно.

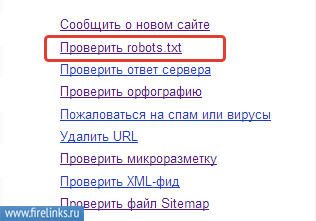

Следующим шагом, нам необходимо добавить наш файл в панель яндекс-вебмастер. Делается это следующим способом. Для начала заходим в вебмастер, далее переходим в раздел “Проверить robots.txt”

Теперь копируем из адресной строки путь к нашему файлу и вставляем его в первую строку панели и нажимаем “Загрузить” и “Проверить”. Яндекс проверит только директивы, которые будет воспринимать именно он, остальные он отсеет.

Отлично. Все основные моменты мы рассмотрели и научились составлять правильный файл robots.txt при создании своих сайтов. Советую попрактиковаться и проверить отдачу от новых настроек и качество индексации сайта. Скрывайте весь мусор и следите за индексацией страниц. Данные настройки мне очень помогают и процесс индекса занимается всего несколько дней в Яндексе. Про Гугл и не говорю, там все как всегда супер, скорость попадания страниц в индекс всего несколько часов.

Надеюсь, материал будет полезен моим дорогим читателям. Подписывайтесь на обновления блога. Буду благодарен за нажатии кнопочек и репост данного материала. Увидимся в следующих статьях. Всем удачи.

С уважением, Галиулин Руслан.